Consul 集群搭建

不知道 Consul 用的人多还是少,最近有人问怎么搭建 Consul 集群,这里顺手记录一下吧

一、简介

Consul 与 Etcd 一样,都属于分布式一致性数据库,其主要特性就是在分布式系统中出现意外情况如节点宕机的情况下保证数据的一致性;相对于 Etcd 来说,Consul 提供了更加实用的其他功能特性,如 DNS、健康检查、服务发现、多数据中心等,同时还有 web ui 界面,体验相对于更加友好

二、环境准备

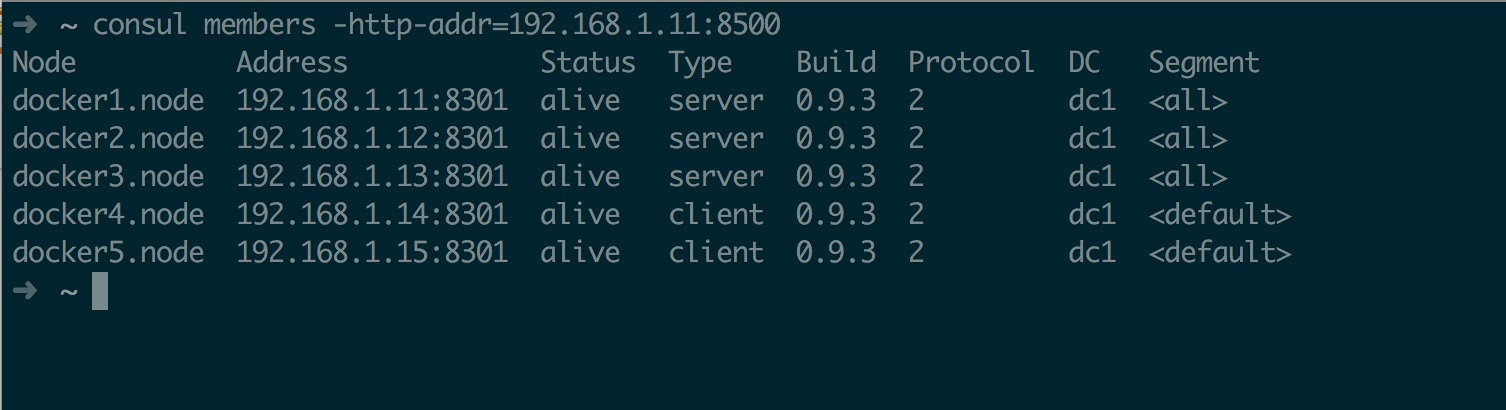

同 Etcd 一样,Consul 最少也需要 3 台机器,这里测试实用 5 台机器进行部署集群,具体环境如下

| 节点 | IP | Version |

|---|---|---|

| server | 192.168.1.11 | v0.9.3 |

| server | 192.168.1.12 | v0.9.3 |

| server | 192.168.1.13 | v0.9.3 |

| client | 192.168.1.14 | v0.9.3 |

| client | 192.168.1.15 | v0.9.3 |

其中 consul 采用 rpm 包的形式进行安装,这里并没有使用 docker 方式启动是因为个人习惯重要的数据存储服务交给 systemd管理;因为 docker 存在 docker daemon 的原因,如果用 docker 启动这种存储核心数据的组件,一但 daemon 出现问题那么所有容器都将出现问题;所以个人还是比较习惯将 etcd 和 consul 以二进制装在宿主机,由 systemd 直接管理。

三、部署集群

3.1、Consul 集群模式

Consul 集群与 Etcd 略有区别,Consul 在启动后分为两种模式:

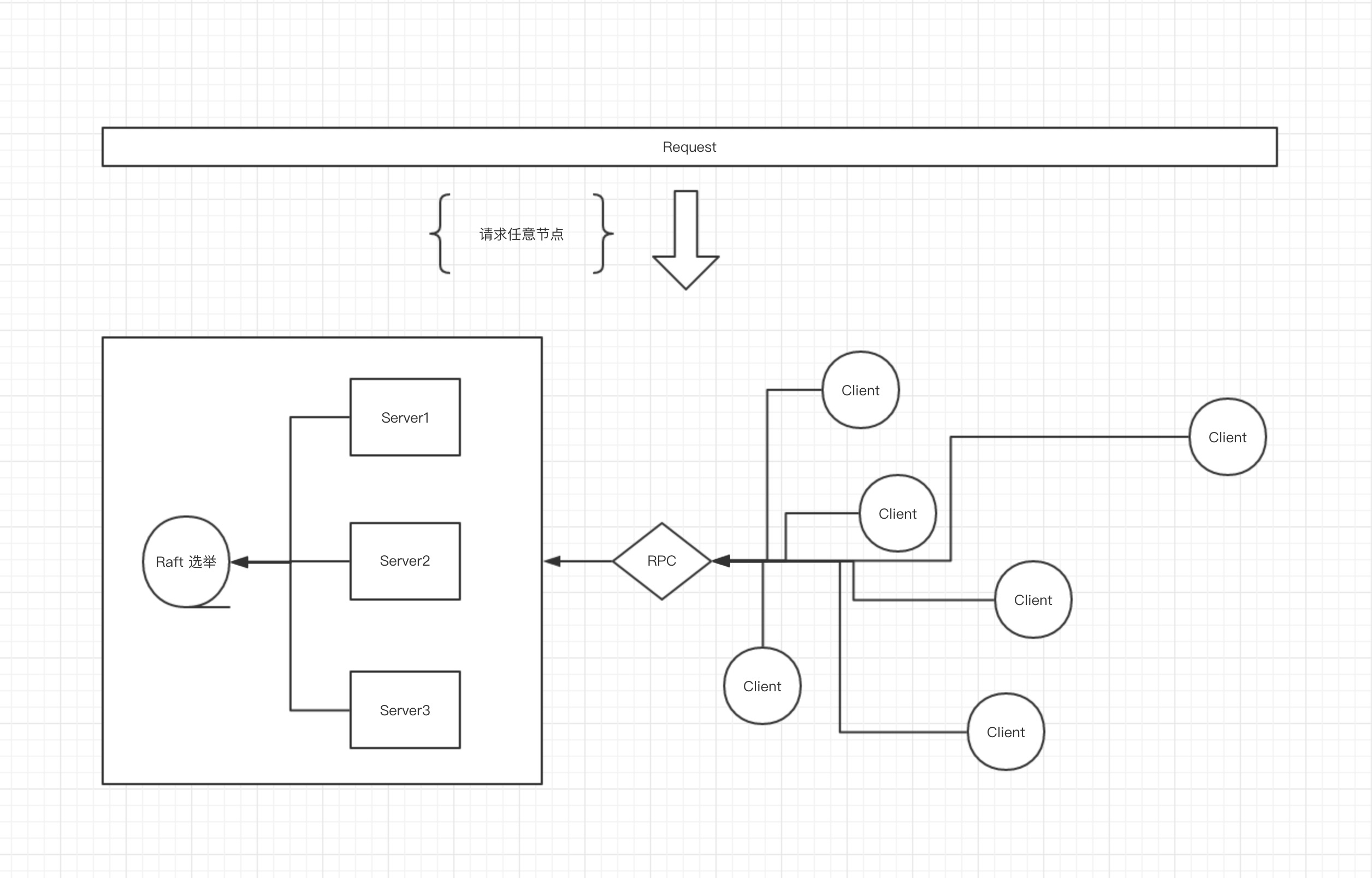

- Server 模式: 一个 Server 是一个有一组扩展功能的代理,这些功能包括参与 Raft 选举,维护集群状态,响应 RPC 查询,与其他数据中心交互 WAN gossip 和转发查询给 leader 或者远程数据中心。

- Client 模式: 一个 Client 是一个转发所有 RPC 到 Server 的代理。这个 Client 是相对无状态的;Client 唯一执行的后台活动是加入 LAN gossip 池,这有一个最低的资源开销并且仅消耗少量的网络带宽。

其集群后如下所示:

3.2、集群搭建

Consul 集群搭建时一般提供两种模式:

- 手动模式: 启动第一个节点后,此时此节点处于 bootstrap 模式,其节点手动执行加入

- 自动模式: 启动第一个节点后,在其他节点配置好尝试加入的目标节点,然后等待其自动加入(不需要人为命令加入)

这里采用自动加入模式,搭建过程如下:

首先获取 Consul 的 rpm 包,鉴于官方并未提供 rpm 安装包,所以我自己造了一个轮子,打包脚本见 Github,以下直接从我的 yum 源中安装

1 | |

5 台机器安装好后修改其中三台为 Server 模式并启动

1 | |

另外两个节点与以上配置大致相同,差别在于其他两个 Server 节点 bootstrap_expect 值为 2,即期望启动时已经有两个节点就绪;然后依次启动三个 Server 节点即可

1 | |

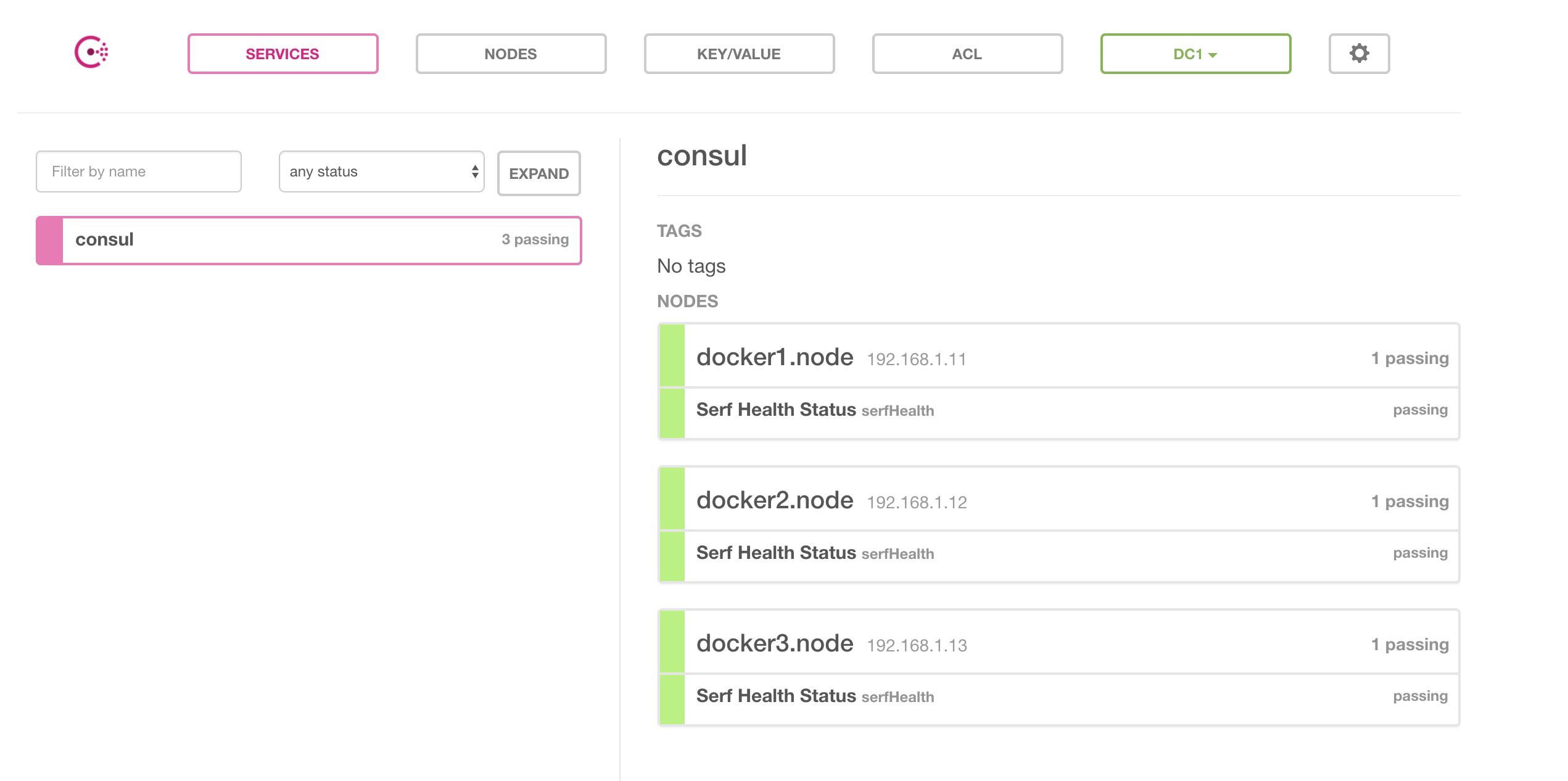

此时可访问任意一台 Server 节点的 UI 界面,地址为 http://serverIP:8500,截图如下

接下来修改其他两个节点配置,使其作为 Client 加入到集群即可,注意的是当处于 Client 模式时,bootstrap_expect 必须为 0,即关闭状态;具体配置如下

1 | |

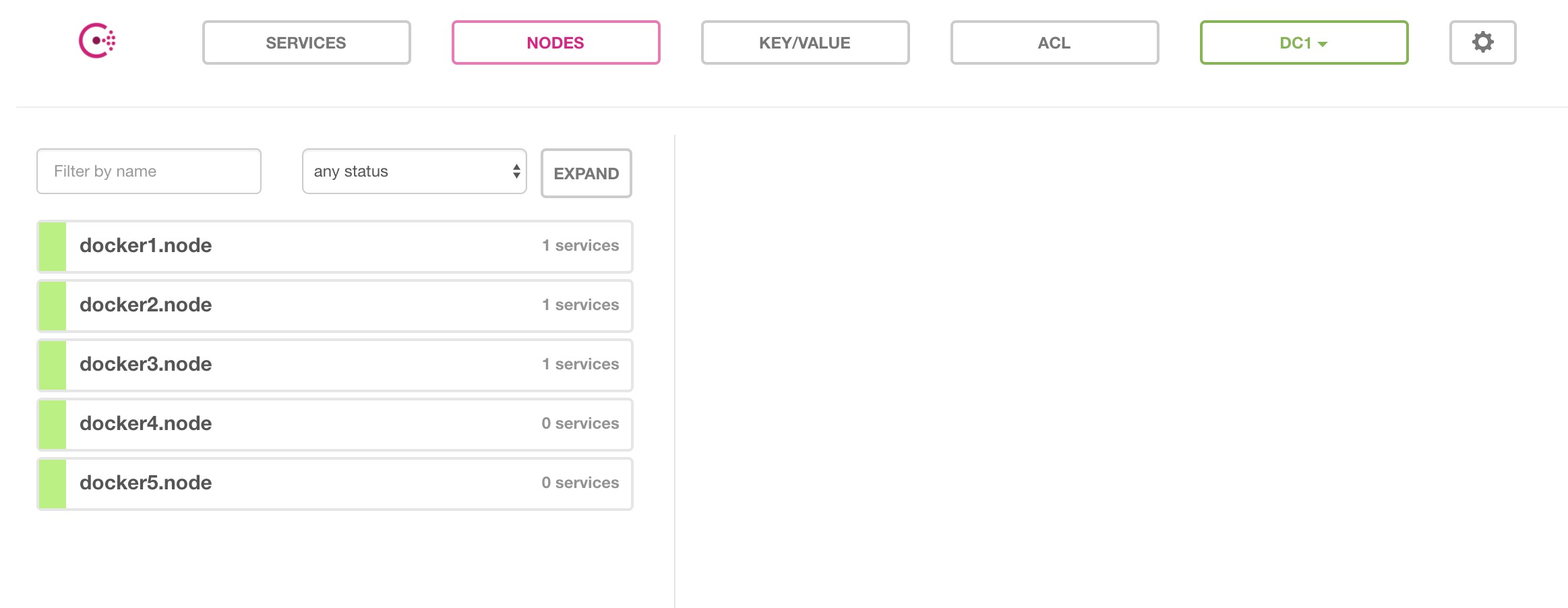

另外一个 Client 配置与以上相同,最终集群成功后如下所示

四、其他说明

关于 Consul 的其他各种参数说明,中文版可参考 Consul集群部署;这个文章对大体上讲的基本很全了,但是随着版本变化,有些参数还是需要参考一下 官方配置文档